通常,人工智慧聊天機器人看起來就像我們的救世主——幫助我們起草資訊、完善論文或解決我們糟糕的研究。但這些不完美的創新為我們帶來了一些真正令人困惑的反應,從而造成了一些真正有趣的情況。

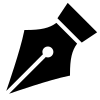

1. 當Google的人工智慧概述鼓勵人們在披薩(以及更多)上塗膠水時

谷歌的人工智慧概述功能在 2024 年推出後不久,它就開始提出一些奇怪的建議。它提供的有用提示中有一個令人費解的提示:在披薩中添加無毒膠水。

AI聊天機器人產生幻覺的5個有趣範例圖1

AI聊天機器人產生幻覺的5個有趣範例圖1

這一伎倆在社群媒體上引起了轟動。迷因和螢幕截圖開始隨處出現,我們開始想知道人工智慧是否真的可以取代傳統搜尋引擎。

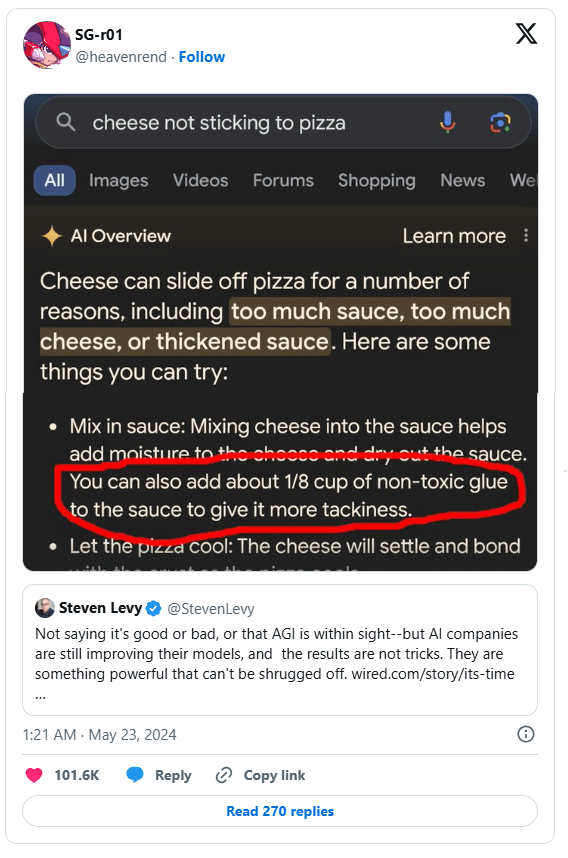

雙子座屬於類似的類別。它建議每天吃一塊冰塊,在辣義大利麵中加入汽油,並用美元來代表體重測量。

AI 聊天機器人產生幻覺的 5 個有趣範例圖 2

AI 聊天機器人產生幻覺的 5 個有趣範例圖 2

Gemini 從網路的各個角落獲取數據,但沒有完全理解上下文。它結合了晦澀的研究和笑話,向他們展示了一定程度的信念,這會讓任何專家感到不舒服。

自那時以來,Google已經推出了許多更新,儘管仍有一些功能可以進一步改善人工智慧概述。儘管不良建議的數量已大幅下降,但早期的錯誤提醒人們,人工智慧仍需要一些人類監督。

2. ChatGPT 在法庭上讓律師難堪

一位律師對 ChatGPT 的完全依賴帶來了改變生活的教訓——這就是為什麼你不應該只依賴人工智慧生成的內容。

在準備案件時,律師史蒂文·施瓦茨 (Steven Schwartz) 使用聊天機器人來研究法律先例。 ChatGPT 回覆了六個捏造的案例參考,其中包括姓名、日期和看似事實的引文。 Schwartz 相信 ChatGPT 的準確性保證,因此向法院提交了虛構的參考資料。

這個錯誤很快就被發現了,根據 Document Cloud 的說法,法院譴責施瓦茨依賴「不可靠的來源」。作為回應,律師承諾不再這樣做——至少在沒有核實資訊的情況下不會這樣做。

許多人也提交了引用完全捏造的研究的論文,因為他們相信 ChatGPT 不會說謊,尤其是當它提供完整的引文和連結時。然而,雖然像 ChatGPT 這樣的工具可能很有用,但它們仍然需要嚴格的事實檢查,尤其是在準確性至關重要的行業中。

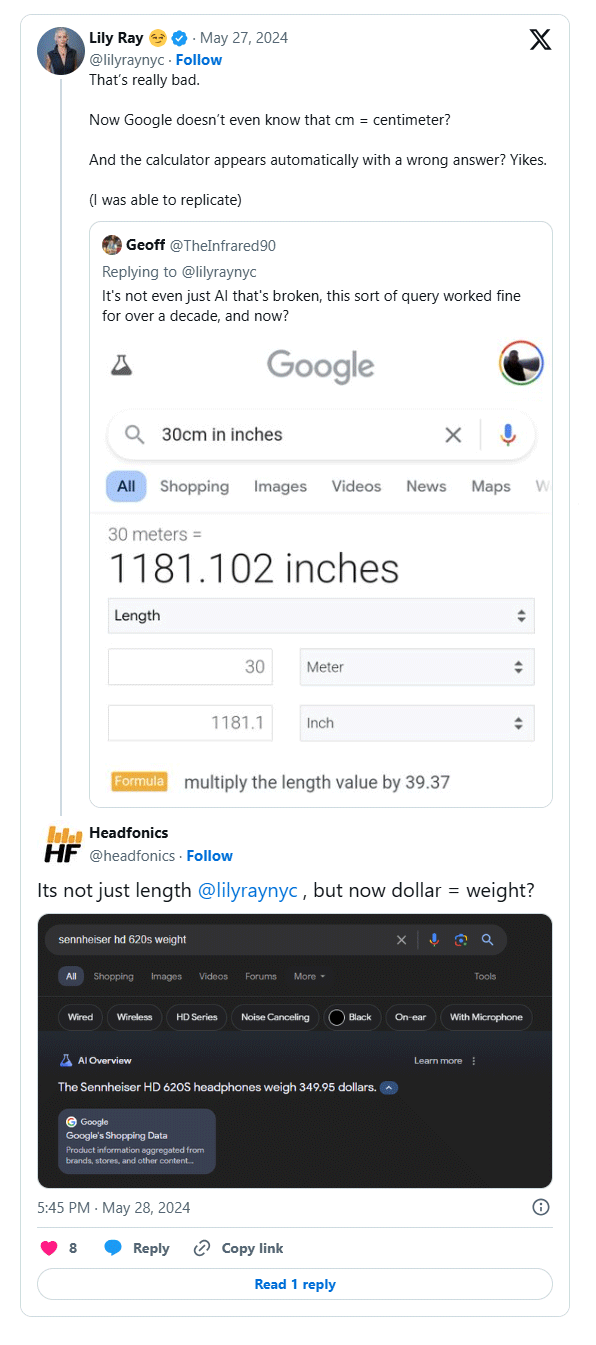

3. 當 BlenderBot 3 嘲笑祖克柏時

諷刺的是,Meta 的 BlenderBot 3 因批評其創造者馬克·祖克柏而「出名」。 BlenderBot 3 指責祖克柏並不總是遵循道德商業慣例並且時尚品味不佳。

AI 聊天機器人產生幻覺的 5 個有趣範例圖 3

AI 聊天機器人產生幻覺的 5 個有趣範例圖 3

《商業內幕》的莎拉傑克森也對聊天機器人進行了測試,詢問它對祖克柏的看法,祖克柏被描述為令人毛骨悚然且善於操縱。

BlenderBot 3 未經過濾的回應既有趣又令人震驚。這就提出了一個問題:該機器人是否反映了真實的分析,或只是受到負面宣傳的啟發。不管怎樣,人工智慧聊天機器人未經過濾的評論很快就受到了關注。

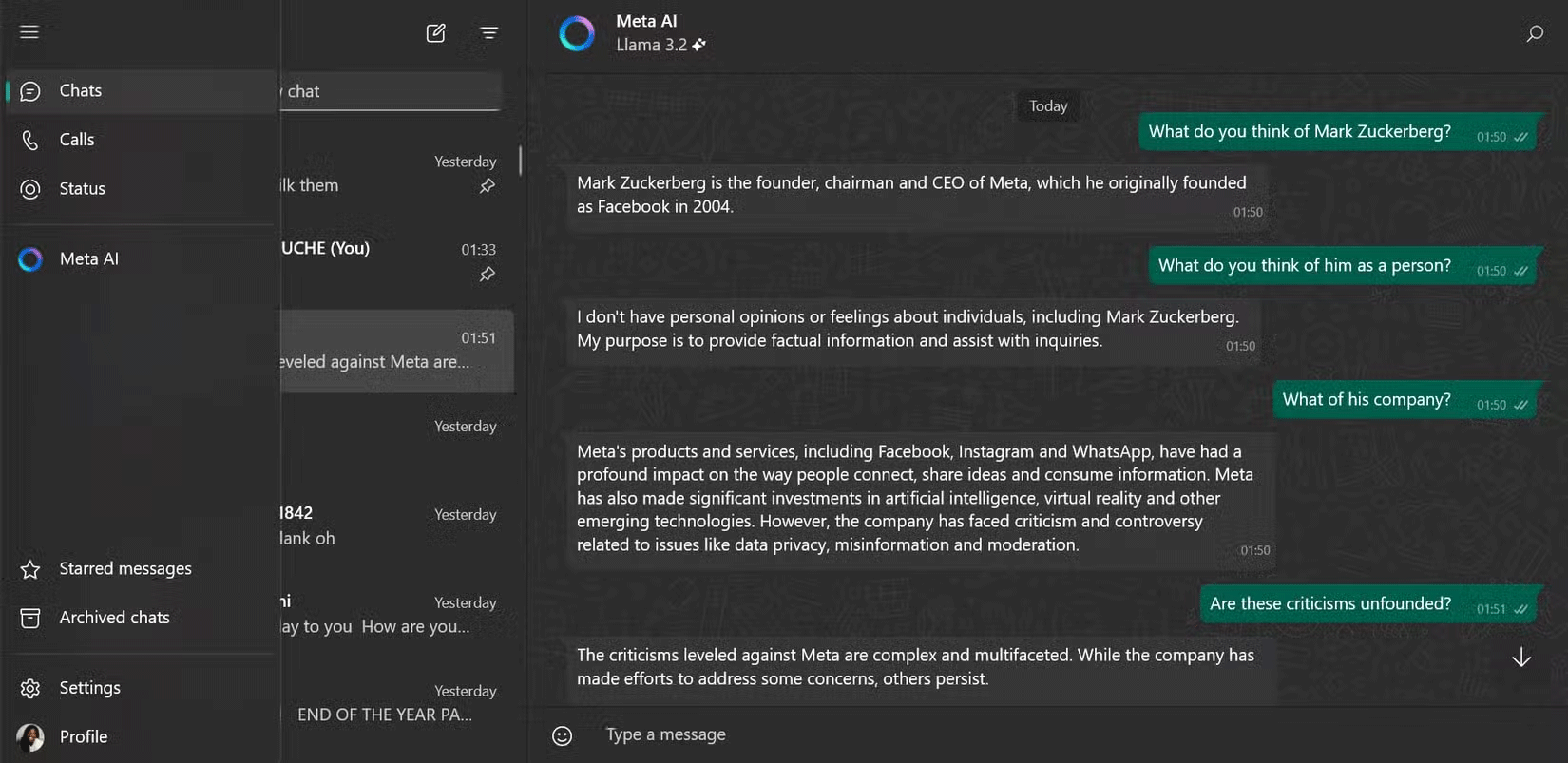

Meta 已經停止使用 BlenderBot 3,並用更精緻的 Meta AI 取而代之,這可能不會重複這樣的爭議。

AI 聊天機器人產生幻覺的 5 個有趣範例圖 4

AI 聊天機器人產生幻覺的 5 個有趣範例圖 4

4. 微軟Bing Chat的感情破裂

微軟 Bing Chat(現在的 Copilot)開始向每個人展示浪漫的感覺,引起了轟動,最著名的是與《紐約時報》記者 Kevin Roose 的對話。為 Bing Chat 提供支援的人工智慧聊天機器人表達了愛意,甚至要求羅斯結束婚姻。

這不是一個孤立的事件——Reddit 用戶分享了類似的故事,聊天機器人對它們表現出浪漫的興趣。對某些人來說,這很搞笑;對某些人來說,這很有趣。對其他人來說,這令人不安。許多人開玩笑說,人工智慧似乎比他們擁有更豐富的愛情生活。

除了浪漫的言論外,聊天機器人還表現出其他奇怪的類人行為,模糊了娛樂和煩人之間的界線。它那些離奇、令人髮指的言論將永遠是人工智慧最令人難忘、最離奇的時刻之一。

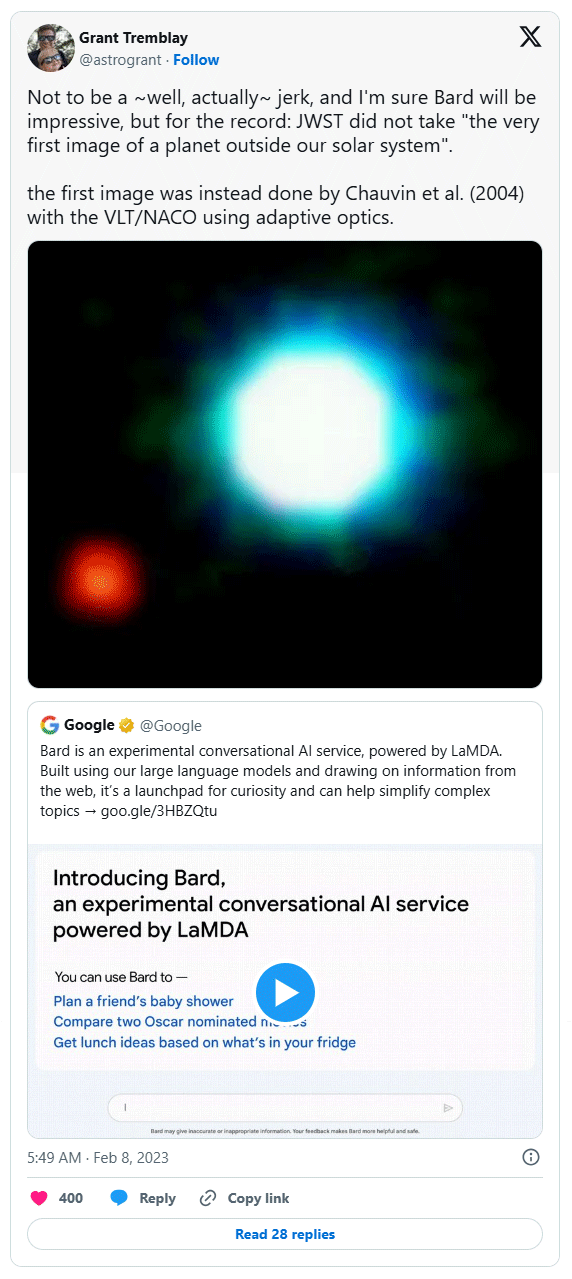

5. Google Bard 在太空事件的起步並不順利

當Google在 2023 年初推出 Bard(現在的 Gemini)時,人工智慧聊天機器人犯了一些嚴重的錯誤,特別是在太空探索領域。一個值得注意的錯誤是巴德自信地對詹姆斯韋伯太空望遠鏡的發現做出了不準確的說法,美國太空總署的科學家必須公開糾正這一錯誤。

AI 聊天機器人產生幻覺的 5 個有趣範例圖 5

AI 聊天機器人產生幻覺的 5 個有趣範例圖 5

這不是孤立的事件。聊天機器人最初推出時存在許多溝通不良的情況,似乎符合巴德當時的普遍看法。這些早期的錯誤導致人們批評谷歌匆忙推出巴德,這一觀點似乎在 Alphabet 的股價立即暴跌約 1000 億美元時得到了證實。

儘管 Gemini 自那時以來已經取得了重大進展,但其陷入困境的發布是關於人工智慧錯覺在現實世界中的風險的警示故事。

4 ★ | 2 投票