什么是TPU(张量处理单元),如何使用?

Google的TensorFlow平台允许用户通过提供机器学习的工具和资源来训练AI。 AI工程师长期以来一直使用传统的CPU和GPU来训练AI。尽管这些处理器可以处理各种机器学习过程,但它们仍然是通用的硬件,用于各种日常任务。

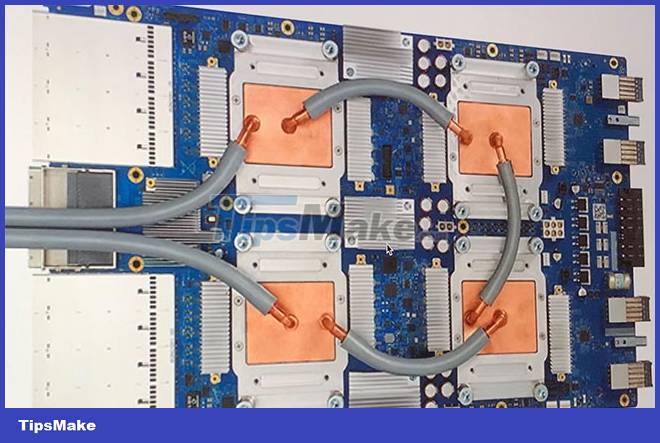

为了加快AI培训,Google开发了一个特定于应用程序的集成电路(ASIC),称为张量处理单元(TPU)。但是,什么是张量处理单元,如何加快AI编程?

什么是张量处理单元(TPU)?

张量处理单元是Google用于机器学习的ASIC。 TPU专门用于深度学习来求解复杂的矩阵和向量数学。将TPU简化以以闪电速度求解矩阵和向量操作,但必须与CPU配对才能发行和执行指令。 TPU只能与Google的TensorFlow或Tensorflow Lite平台一起使用,无论是通过云还是本地硬件上的Lite版本。

TPU的申请

Google自2015年以来一直在使用TPU。它还证实了这些新处理器在Google Street View,Google Photos和Google搜索结果(Rank Brain)以及创建一个名为Alphago的AI中使用这些新处理器进行文字处理,并创建了一个名为Alphago的AI,该AI击败了最强的GO播放器,并且Alphazero System在Chess,Go和Shogi中赢得了Alphazero System的赢得。

TPU可用于各种深度学习应用程序,例如欺诈检测,计算机视觉,自然语言处理,自动驾驶汽车,语音AI,农业,虚拟助手,交易股票,电子商务和各种社会预测。

什么时候使用TPU?

由于TPU是高度专业化的硬件,因此它会失去通常会从CPU(例如CPU)等通用处理器中期望的许多其他功能。考虑到这一点,在特定情况下,在训练AI时,使用TPU将产生最佳结果。

使用TPU的最佳时间是用于模型在很大程度上依赖矩阵计算的操作,例如搜索引擎的推荐系统。 TPU还为AI分析大量数据点的模型提供了出色的结果,这些数据点需要数周或数月才能完成。人工智能工程师使用TPU对于不可用自定义TensorFlow模型并且必须从头开始。

什么时候不使用TPU?

如前所述,TPU优化使这些类型的处理器仅在特定的工作负载上工作。因此,在某些情况下,选择使用传统的CPU和GPU会产生更快的结果。这些案例包括:

- 快速原型制作具有最大灵活性

- 模型受到可用数据点的限制

- 这些模型很简单,可以快速训练

- 模型太难更改了

- 模型取决于用C ++编写的自定义张量流操作

TPU版本和规格

自Google宣布其TPU以来,公众一直在最新的TPU版本及其规格上不断更新。以下是所有TPU版本的列表,并附有附带规格:

| TPUV1 | TPUV2 | TPUV3 | TPUV4 | EDGEV1 | |

|---|---|---|---|---|---|

| 会议日 | 2016 | 2017 | 2018 | 2021 | 2018 |

| 处理节点(NM) | 28 | 16 | 16 | 7 | |

| 霉菌尺寸(mm²) | 331 | <625 | <700 | <400 | |

| 片上内存 | 28 | 32 | 32 | 144 | |

| 时钟速度(MHz) | 700 | 700 | 940 | 1050 | |

| 最小内存配置(GB) | 8 DDR3 | 16 hbm | 32小时 | 32小时 | |

| TDP(瓦特) | 75 | 280 | 450 | 175 | 2 |

| 顶部(TERA操作每秒) | 23 | 45 | 90 | ? | 4 |

| 顶部/w | 0.3 | 0.16 | 0.2 | ? | 2 |

如您所见,TPU时钟速度似乎并不令人印象深刻,尤其是因为今天的现代台式机的时钟速度可以快3-5倍。但是,如果您查看桌子的底部两行,您会看到TPU只能使用0.16-0.3瓦的功率处理23-90台TERA运行。使用神经网络界面时,TPU估计是现代CPU和GPU的15-30倍。

每次发布时,新的TPU都会显示出显着的改进和功能。以下是每个版本的一些亮点。

- tpuv1:第一个公开宣布的TPU。设计为8位矩阵乘法引擎,仅限于求解整数。

- tpuv2:正如工程师指出的那样,TPUV1受到带宽的约束。现在,此版本的内存带宽是16GB的RAM。此版本现在可以处理浮点数,使其可用于培训和参考。

- tpuv3:TPUV3于2018年发行,具有两倍的处理器,并以TPUV2的芯片数量多4倍。升级使该版本的性能最高为8倍。

- tpuv4:这是2021年5月18日宣布的TPU的最新版本。GoogleCEO宣布,此版本的性能将是TPU V3的两倍以上。

- 边缘TPU:在整体性能中,此版本的TPU用于较小的活动,可与其他TPU版本相比使用少于其他TPU版本。尽管仅使用了2瓦的功率,但边缘TPU每秒最多可处理4个活动台。 Edge TPU仅在Google的Pixel 4智能手机等小型手机上找到。

如何访问TPU?谁可以使用它们?

TPU是由Google设计的专有处理单元,可与TensorFlow平台一起使用。自2018年以来,已经允许第三方访问这些处理器。今天,TPU(Edge TPU除外)只能通过Google的计算服务访问云。云。虽然Edge TPU硬件可以通过Google的Pixel 4智能手机及其原型发电机(称为Coral)购买。

Coral是使用USB 3.0类型C用于数据和功率的USB加速器。它为您的设备边缘TPU计算提供了每2W功率的4个顶部。该工具包可以在Windows 10,MacOS和Debian Linux机器上运行(也可以与Raspberry Pi一起使用)。

其他专用的AI加速器

在过去十年中,随着人工智能的趋势,Big Tech一直在寻找使机器学习尽可能快速有效的方法。尽管Google的TPU可以说是为深度学习开发的最流行的ASIC,但英特尔,微软,阿里巴巴和高通等其他科技公司也开发了自己的AI加速器。其中包括Microsoft Brainwave,Intel神经计算棒和Graphicore的IPU(智能处理单元)。

但是,尽管正在开发更多的AI硬件,但可悲的是,大多数硬件尚未投放市场,而且其中大部分都不会。在撰写本文时,如果您真的想购买AI-Aclerated硬件,那么最受欢迎的选择是购买珊瑚原型套件,Intel NCS,Graphicore Bow Pod或Asus IoT AI Accelerator。如果您只想访问专门的AI硬件,则可以使用Google的云服务或Microsoft Brainwave等其他替代方案。

![如何重置iPhone密码而不会丢失数据[2024更新]](https://ksfboa.com/tech/jacki/wp-content/uploads/cache/2025/04/how-to-reset-iphone-passcode-without-losing-data.webp.webp.webp)

![[固定] face ID和密码不在iPhone上的设置中](https://ksfboa.com/tech/jacki/wp-content/uploads/cache/2025/05/face-id-and-passcode-not-in-settings.webp.webp)