通常,人工智能聊天机器人看起来就像我们的救世主——帮助我们起草信息、完善论文或解决我们糟糕的研究。但这些不完美的创新给我们带来了一些真正令人困惑的反应,从而造成了一些真正搞笑的情况。

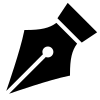

1. 当谷歌的人工智能概述鼓励人们在披萨(以及更多)上涂胶水时

谷歌的人工智能概述功能于 2024 年推出后不久,它就开始提出一些奇怪的建议。它提供的有用提示中有一个令人费解的提示:在披萨中添加无毒胶水。

AI聊天机器人产生幻觉的5个有趣例子图1

AI聊天机器人产生幻觉的5个有趣例子图1

这一伎俩在社交媒体上引起了轰动。模因和屏幕截图开始随处出现,我们开始想知道人工智能是否真的可以取代传统搜索引擎。

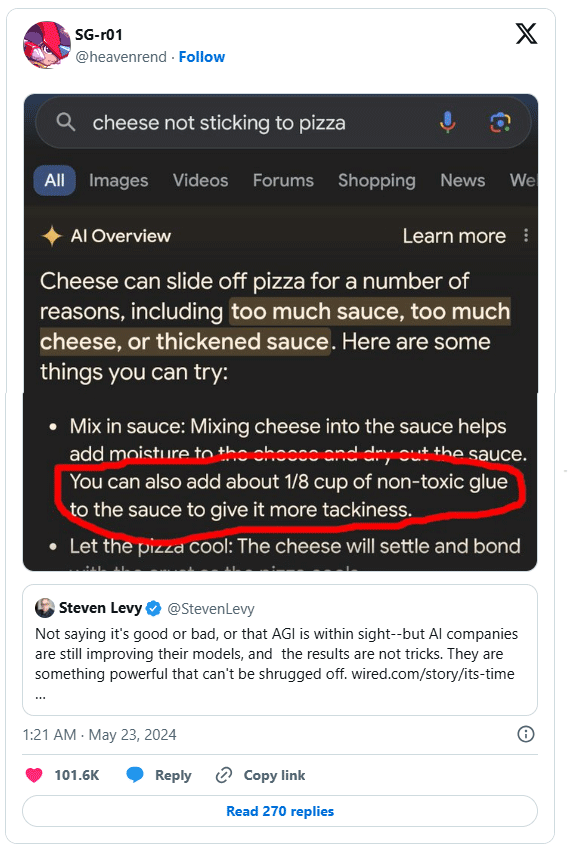

双子座属于类似的类别。它建议每天吃一块冰块,在辣意大利面中加入汽油,并用美元来代表体重测量。

AI 聊天机器人产生幻觉的 5 个有趣例子图 2

AI 聊天机器人产生幻觉的 5 个有趣例子图 2

Gemini 从网络的各个角落获取数据,但没有完全理解上下文。它结合了晦涩的研究和笑话,向他们展示了一定程度的信念,这会让任何专家感到不舒服。

自那时以来,谷歌已经推出了许多更新,尽管仍有一些功能可以进一步改进人工智能概述。尽管不良建议的数量已大幅下降,但早期的错误提醒人们,人工智能仍然需要一些人类监督。

2. ChatGPT 在法庭上让律师难堪

一位律师对 ChatGPT 的完全依赖带来了改变生活的教训——这就是为什么你不应该仅仅依赖人工智能生成的内容。

在准备案件时,律师史蒂文·施瓦茨 (Steven Schwartz) 使用聊天机器人来研究法律先例。 ChatGPT 回复了六个捏造的案例参考,其中包括姓名、日期和看似事实的引文。 Schwartz 相信 ChatGPT 的准确性保证,因此向法院提交了虚构的参考资料。

这个错误很快就被发现了,根据 Document Cloud 的说法,法院谴责施瓦茨依赖“不可靠的来源”。作为回应,律师承诺不再这样做——至少在没有核实信息的情况下不会这样做。

许多人还提交了引用完全捏造的研究的论文,因为他们相信 ChatGPT 不会说谎,尤其是当它提供完整的引文和链接时。然而,虽然像 ChatGPT 这样的工具可能很有用,但它们仍然需要严格的事实检查,尤其是在准确性至关重要的行业中。

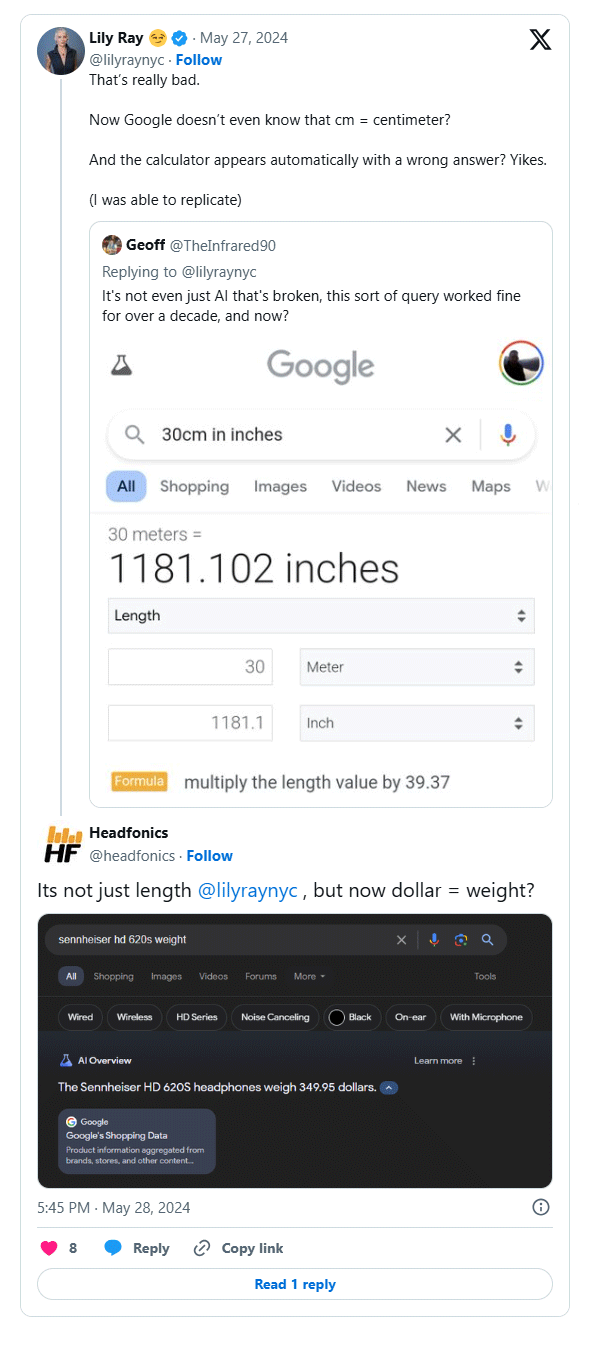

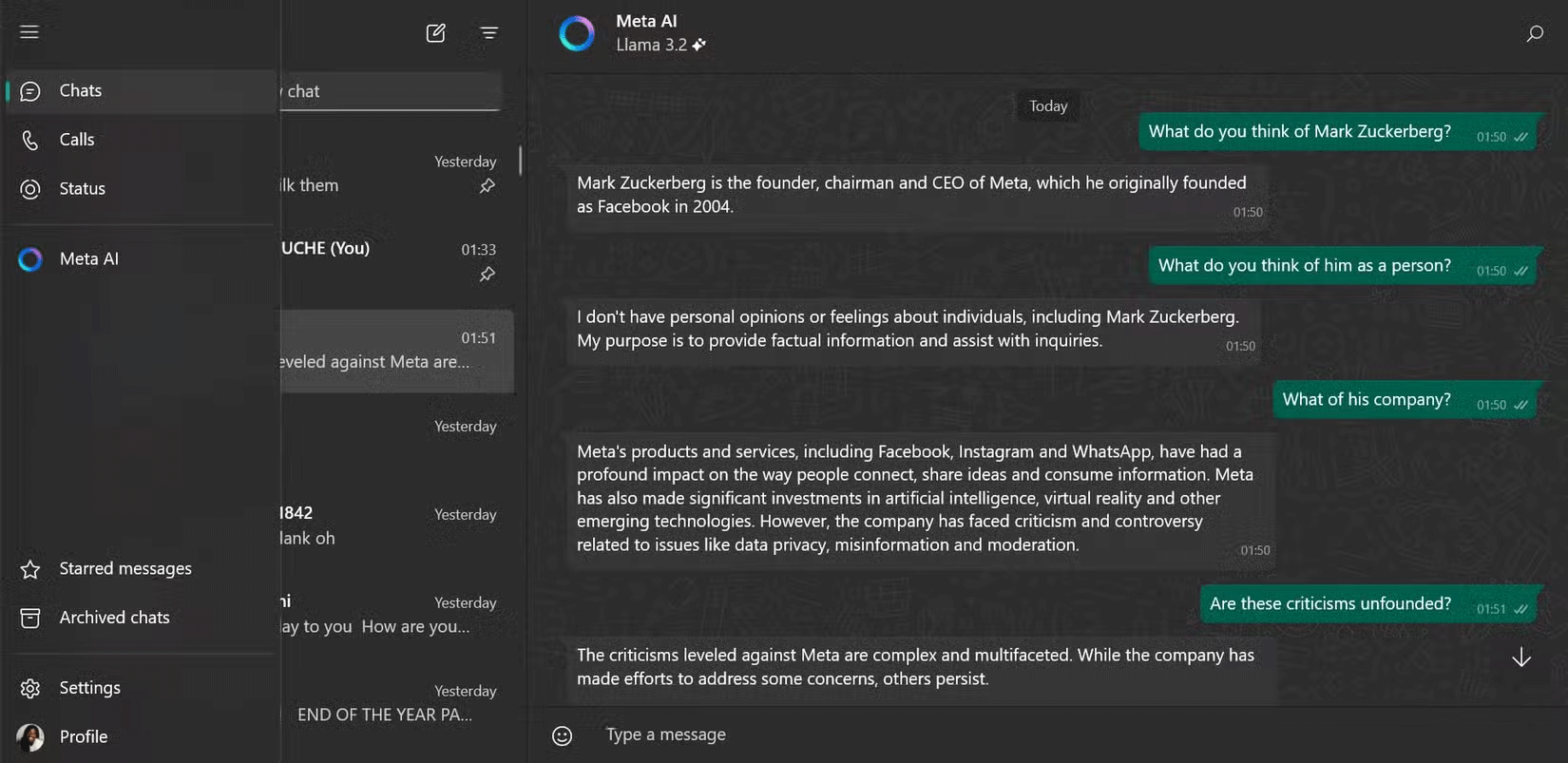

3. 当 BlenderBot 3 嘲笑扎克伯格时

具有讽刺意味的是,Meta 的 BlenderBot 3 因批评其创造者马克·扎克伯格而“出名”。 BlenderBot 3 指责扎克伯格并不总是遵循道德商业惯例并且时尚品味不佳。

AI 聊天机器人产生幻觉的 5 个有趣例子图 3

AI 聊天机器人产生幻觉的 5 个有趣例子图 3

《商业内幕》的莎拉·杰克逊也对聊天机器人进行了测试,询问它对扎克伯格的看法,扎克伯格被描述为令人毛骨悚然且善于操纵。

BlenderBot 3 未经过滤的响应既有趣又令人震惊。这就提出了一个问题:该机器人是否反映了真实的分析,或者仅仅是受到负面宣传的启发。不管怎样,人工智能聊天机器人未经过滤的评论很快就受到了关注。

Meta 已经停止使用 BlenderBot 3,并用更精致的 Meta AI 取而代之,这可能不会重复这样的争议。

AI 聊天机器人产生幻觉的 5 个有趣例子图 4

AI 聊天机器人产生幻觉的 5 个有趣例子图 4

4. 微软Bing Chat的感情破裂

微软 Bing Chat(现在的 Copilot)开始向每个人展示浪漫的感觉,引起了轰动,最著名的是与《纽约时报》记者 Kevin Roose 的对话。为 Bing Chat 提供支持的人工智能聊天机器人表达了爱意,甚至要求罗斯结束婚姻。

这不是一个孤立的事件——Reddit 用户分享了类似的故事,聊天机器人对它们表现出浪漫的兴趣。对一些人来说,这很搞笑;对一些人来说,这很有趣。对于其他人来说,这令人不安。许多人开玩笑说,人工智能似乎比他们拥有更丰富的爱情生活。

除了浪漫的言论外,聊天机器人还表现出其他奇怪的类人行为,模糊了娱乐和烦人之间的界限。它那些离奇、令人发指的言论将永远是人工智能最令人难忘、最离奇的时刻之一。

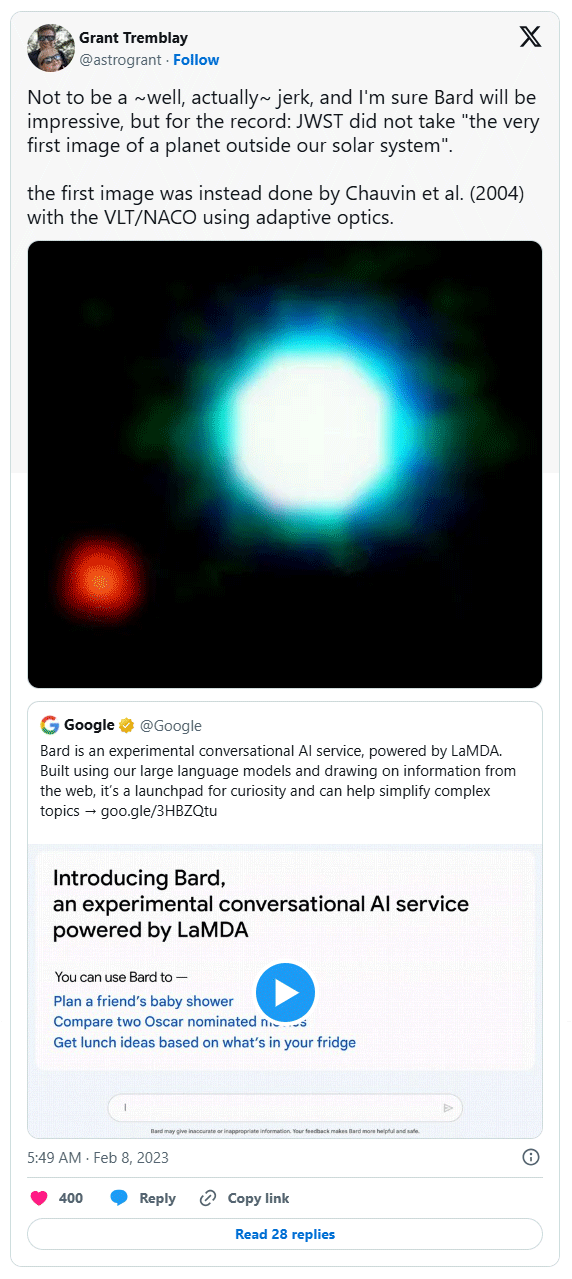

5. Google Bard 在太空事件方面的起步并不顺利

当谷歌在 2023 年初推出 Bard(现在的 Gemini)时,人工智能聊天机器人犯了一些严重的错误,特别是在太空探索领域。一个值得注意的错误是巴德自信地对詹姆斯·韦伯太空望远镜的发现做出了不准确的说法,美国宇航局的科学家必须公开纠正这一错误。

AI 聊天机器人产生幻觉的 5 个有趣例子图 5

AI 聊天机器人产生幻觉的 5 个有趣例子图 5

这不是一个孤立的事件。聊天机器人最初推出时存在许多沟通不畅的情况,这似乎符合巴德当时的普遍看法。这些早期的错误导致人们批评谷歌匆忙推出巴德,这一观点似乎在 Alphabet 的股价立即暴跌约 1000 亿美元时得到了证实。

尽管 Gemini 自那时以来已经取得了重大进展,但其陷入困境的发布是关于人工智能错觉在现实世界中的风险的警示故事。

4 ★ | 2 投票